L’intelligenza artificiale si prefigura come la grande protagonista dell’innovazione tecnologica del futuro prossimo. L’anno scorso ha spinto in altissimo il valore delle aziende più attive nella ricerca. Ora si cominciano a vedere i primi segnali concreti dell’arrivo nelle nostre case: da piccolezze come l’aggiunta di un nuovo tasto sulle tastiere dei prossimi PC, a più importanti programmi governativi sperimentali dove l’intelligenza artificiale diventa strumento di lavoro. Ma qual è lo stato dell’AI ora? Cosa può fare?

Cominciamo col dire che intelligenza artificiale è un termine scelto dal marketing per definire un concetto molto ampio, tant’è vero che esistono diversi tipi di AI. Quella che tiene banco ora è l’AI generativa, ovvero un particolare assieme di programmi per computer in grado di generare un output molto articolato con pochi dati in ingresso.

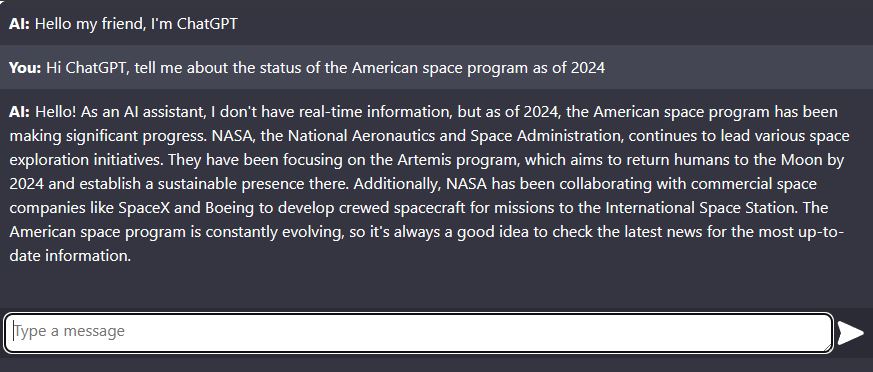

Ad esempio ChatGPT è un’AI in grado di generare un testo di risposta quando l’utente pone una domanda. Stable Diffusion è invece in grado di generare un’immagine quando l’utente inserisce una descrizione.

Se sul vocabolo “artificiale” non c’è molto da discutere (quasi tutto ciò che ci circonda oggi è artificiale), sull’”intelligenza” bisogna invece fare chiarezza. Per il momento si tratta di un’intelligenza molto limitata: ChatGPT è stata creata sottoponendole i testi di migliaia di biblioteche, per cui “conosce” (nel senso che contiene in un modello matematico) la probabilità che ad una parola ne segua un’altra e un’altra ancora fino a formare una frase.

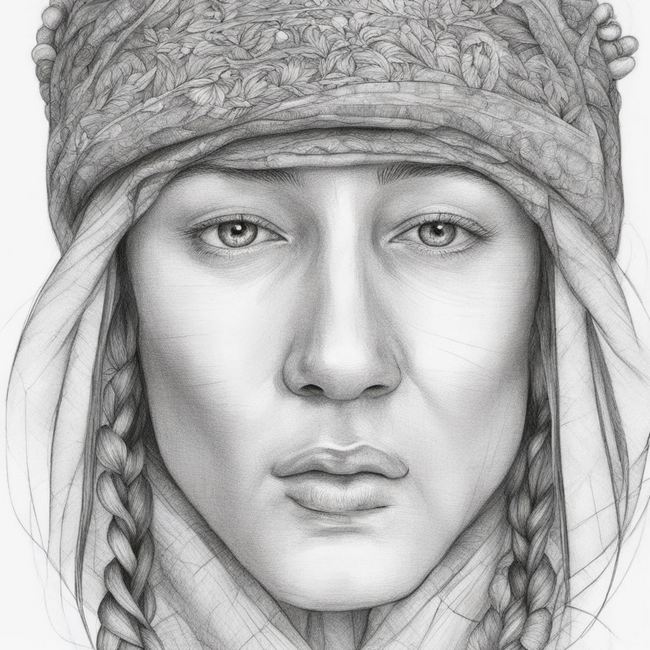

Allo stesso modo Stable Diffusion “ha visto” un sacco di immagini, per cui “sa” che vicino ad un occhio di solito ce n’è un altro, più in basso c’è un naso e poi una bocca fino a formare un viso.

In realtà ChatGPT non conosce il significato di nessuna parola, sa solo che vicino a “Pierino” di solito sta scritto “va” e poi “al mercato”. Stable Diffusion non ha idea di cosa siano un occhio o un naso. Sa solo che, nella richiesta “disegno di una persona”, “disegno” vuol dire ad esempio bianco e nero o colori a pastello, e “persona” vuol dire che in una certa zona dell’immagine ci dev’essere una quantità di pixel color pelle, con due piccole zone chiare (gli occhi) e dentro queste zone chiare ci sono zone più scure (le pupille), eccetera.

Come spesso avviene in informatica, si tratta quindi di una costruzione molto astratta e distante dalla percezione del mondo che abbiamo noi umani. Da un lato questo approccio permette una grande libertà creativa:

Dall’altro è abbastanza evidente che, non sapendo cos’è una corda, disegnare bene un ring sia abbastanza difficile. Stesso discorso per la bandiera americana sulla spalla dell’orso: le strisce sembrano a posto, ma il rettangolo con le stelle è storto. Oppure i vari oggetti sul corpo della tuta: un po’ fuori posto. In compenso l’orso e il tessuto della tuta sono molto migliori di quelli che potrei disegnare io.

Stesso discorso per ChatGPT: anche se il fraseggio è naturale e garbato, non c’è modo di verificare che quanto sta dicendo sia corretto. Spesso inoltre ChatGPT rimane sulle generali e non apporta molto valore alla conversazione.

Per il momento quindi l’AI ha bisogno di stretta supervisione. Può andare bene come primo passaggio per fare un riassunto, o per creare uno schizzo da cui trarre ispirazione per poi correggerlo e rifinirlo. Siamo ancora molto lontani da un’apocalisse robotizzata, ma è giusto vigilare e porsi dei quesiti. Com’è successo nella vicenda del drone che fa fuori il suo operatore per aver più libertà d’azione, finita sui giornali come il resoconto di una simulazione ma in realtà solo uno scenario ipotetico descritto in una conferenza.

Lascia un commento